Google Cloudが「Cloud TPU v5p」発表、AI処理に特化したプロセッサ。前世代より2.8 倍高速に大規模言語モデルをトレーニング。Google Cloud Next '24

今回は「Google Cloudが「Cloud TPU v5p」発表、AI処理に特化したプロセッサ。前世代より2.8 倍高速に大規模言語モデルをトレーニング。Google Cloud Next '24」についてご紹介します。

関連ワード (最大、特化、能力等) についても参考にしながら、ぜひ本記事について議論していってくださいね。

本記事は、Publickey様で掲載されている内容を参考にしておりますので、より詳しく内容を知りたい方は、ページ下の元記事リンクより参照ください。

Google Cloudは、日本時間4月10日未明から開催中のイベント「Google Cloud Next ’24」で、同社が独自に開発しているAI処理に特化したプロセッサ「Cloud TPU」の最新版となる「Cloud TPU v5p」を発表しました。

TPU v5pは前世代のTPU 4と比較して最大4倍の能力を持つとのこと。

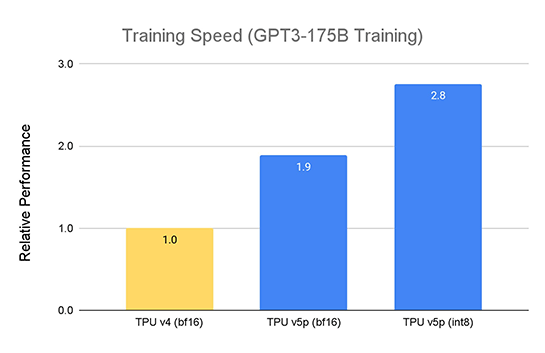

さらに2倍以上の浮動小数点演算性能(FLOPS)と3倍以上の高帯域幅メモリ(HBM)を備え、コストパフォーマンスは2.3倍向上し、2.8倍高速に大規模言語モデル(LLM)をトレーニングできるとしています。

TPUは基本的に多数のチップを集積したポッドとして構成されます。TPU v5pの各ポッドは8960個のチップで構成されており、3Dトーラスのトポロジーで4800Gbps/チップという最高帯域幅のチップ間相互接続(ICI)を実現しているとのことです。